Il est impossible de nier l’influence de Facebook dans la division politique croissante et la division sociale plus largement. Mais dans quelle mesure, exactement, Facebook contribue-t-il à la discussion politique et quels en sont les impacts ultérieurs sur le comportement de vote?

Lors d’une récente conférence à Munich, Le PDG de Facebook, Mark Zuckerberg, a minimisé la responsabilité de Facebook à cet égard, en disant que:

«Les gens sont moins susceptibles de cliquer sur des choses et de s’engager avec eux s’ils ne sont pas d’accord avec eux. Donc, je ne sais pas comment résoudre ce problème. Ce n’est pas autant un problème de technologie qu’un problème d’affirmation humaine. «

Zuckerberg a également noté que les utilisateurs de Facebook sont exposés à un ensemble de points de vue plus diversifié sur Facebook qu’auparavant par le biais des médias traditionnels.Par conséquent, Facebook, à son avis, n’est pas nécessairement à blâmer pour avoir exacerbé la division ou alimenté les chambres d’écho, comme certains l’ont suggéré.

Mais encore, même sur la base de ces déclarations, Facebook contribue à la division et à l’angoisse politique.

Comme l’a noté l’ancien chef de la division des publicités mobiles de Facebook, Andrew Bosworth, plus tôt cette année, si Facebook expose les utilisateurs à plus de perspectives, selon ses conclusions internes, ce n’est pas nécessairement une bonne chose:

« Internet les expose à beaucoup plus de contenu provenant d’autres sources (26% de plus sur Facebook, selon nos recherches). C’est celui que tout le monde se trompe. L’accent mis sur les bulles de filtre fait que les gens passent à côté du vrai désastre qu’est la polarisation. Que se passe-t-il lorsque vous voyez 26% de contenu en plus de personnes avec lesquelles vous n’êtes pas d’accord? Cela vous aide-t-il à sympathiser avec eux comme tout le monde le suggère? Nan. Cela fait que vous ne les aimez pas encore plus. «

Essentiellement, Bosworth et Zuckerberg reconnaissent ici un problème clé, à savoir que Facebook exacerbe la division politique par une plus grande exposition à une plus large diffusion de contenu d’information. Facebook pourrait chercher à minimiser cela, en remettant le fardeau sur les utilisateurs et en notant que ce qu’ils lisent est leur choix. Mais les faits sont assez clairs: Facebook expose sciemment les utilisateurs à plus de contenu qui cause de l’angoisse. Et cela, une fois de plus, a été reflété dans de nouvelles déclarations et rapports cette semaine.

Dans une récente interview avec NBC, le chef d’Instagram Adam Mosseri a fait une note intéressante sur l’engagement d’Instagram contrairement à Facebook:

« Nous avons pu apprendre de certaines des erreurs de Facebook. Les gens se sentent un peu mieux à propos de leur temps passé sur Instagram, probablement parce qu’il est un peu plus concentré sur des choses moins controversées. «

Donc, encore une fois, les dirigeants de Facebook sont conscients des impacts négatifs que l’utilisation de Facebook peut avoir et comment, sur d’autres plates-formes, ce n’est pas aussi présent. Cela étant, pourquoi Facebook ne travaille-t-il pas pour y remédier? Pourquoi, si l’équipe de Facebook sait qu’une exposition accrue à un contenu d’actualité plus polarisant laisse les utilisateurs moins heureux, ne cherche-t-elle pas à réviser son algorithme pour y remédier?

Encore une fois, Facebook, selon la déclaration de Zuckerberg ci-dessus, pourrait chercher à mettre le fardeau sur les utilisateurs et dire qu’il s’agit d’un « problème d’affirmation humaine », mais Facebook pourrait sûrement exercer une certaine influence ici. L’algorithme pourrait sûrement être ajusté en fonction de ces résultats pour créer une expérience utilisateur plus positive et réduire les frictions politiques.

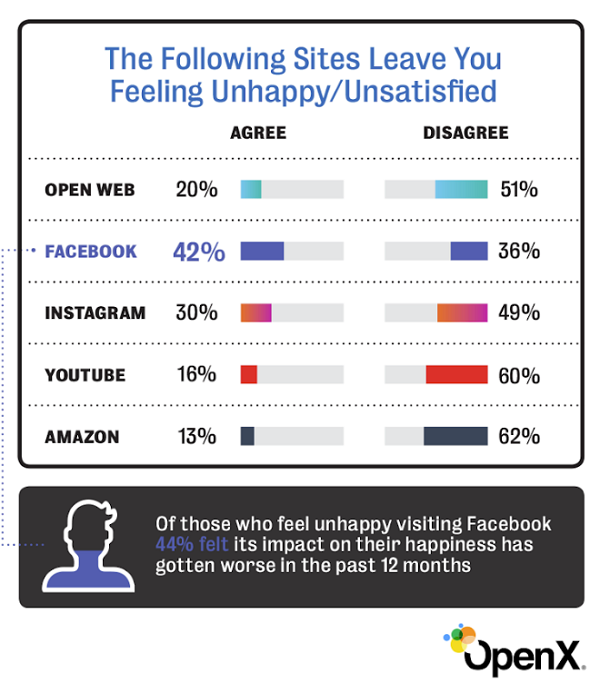

En effet, une nouvelle étude publiée par OpenX a constaté que les utilisateurs se sentent, en fait, de moins en moins satisfaits du temps qu’ils passent sur Facebook.

C’est sûrement une préoccupation et un domaine sur lequel Facebook pourrait s’améliorer, s’il le voulait.

Alors pourquoi pas?

Ce résultat, issu d’une étude sur ce qui rend le contenu plus partageable en ligne, menée en 2010, pourrait être pertinent:

« Les résultats suggèrent une forte relation entre l’émotion et la viralité: un contenu chargé d’affect – qu’il soit positif ou négatif – est plus susceptible de figurer sur la liste la plus envoyée par e-mail. De plus, le contenu positif est plus viral que le contenu négatif; cependant, ce lien est complexe. Alors que le contenu plus impressionnant et plus surprenant est plus susceptible de figurer sur la liste la plus envoyée par courrier électronique et que le contenu induisant la tristesse est moins viral, certaines émotions négatives sont positivement associées à la viralité. Un contenu plus anxieux et induisant de la colère est à la fois plus susceptible de figurer sur la liste la plus envoyée par e-mail. En fait, le prédicteur le plus puissant de la viralité dans leur modèle est la quantité de colère qu’un article suscite. «

La colère est le prédicteur le plus puissant de la viralité. Le contenu qui incite à la colère est le plus susceptible d’être partagé en ligne.

C’est là que la défense de Facebook de ses systèmes, et de son algorithme de fil d’actualité en particulier, devient un peu fragile – dans une autre section de l’interview de NBC avec Mosseri, il note que:

« [Facebook invests] plus que quiconque dans ces problèmes. Vous pouvez être en désaccord avec des décisions de politique ou des décisions d’application spécifiques. Mais les gens qui nous accusent maintenant de ne pas avoir de bonnes intentions, de ne pas vraiment essayer de prendre notre responsabilité au sérieux et de ne pas investir de manière appropriée pour résoudre ces problèmes, ne regardent tout simplement pas les faits réels. «

Et c’est vrai dans une large mesure. Mais Facebook est aussi une entreprise, qui connaît une croissance continue d’année en année. Et comme tous les médias le savent, susciter une réponse émotionnelle est ce qui maximise l’engagement. Facebook le sait aussi, et la colère suscitant le plus d’engagement, il semble logique que Facebook soit au moins heureux de fermer les yeux sur les impacts négatifs potentiels de tels effets, car cela aide la plate-forme à générer plus d’interaction et de temps passé.

C’est peut-être pour cette raison que Facebook a tenu à pousser si fort les groupes ces derniers temps – si plus de personnes prennent davantage leurs conversations qui divisent dans des groupes privés, cela limite l’exposition à la même chose dans le fil d’actualité, ce qui permettrait à Facebook de bénéficier de l’émotionnel / réponse en colère à de tels messages tout en réduisant l’impact plus large sur les utilisateurs moins intéressés.

Vous n’avez peut-être pas un intérêt majeur, par exemple, dans la présidence de Donald Trump, mais voir un message malavisé de votre oncle soutenant Trump pourrait déclencher une réponse émotionnelle. Transférer l’affichage de cet oncle dans un groupe privé et le risque d’exposition est diminué.

Cela fait peut-être partie de la stratégie des groupes de Facebook?

Il est difficile de dire quelle influence Facebook a à cet égard et comment elle peut être résolue, mais avec une telle part d’Internet alimentée par un contenu diviseur et sensationnaliste, il n’est vraiment pas étonnant que la division politique soit devenue si extrême. Et Facebook, quelle que soit la façon dont ses dirigeants pourraient le faire tourner, joue un rôle important à cet égard.

Cela pourrait-il être résolu en modifiant l’algorithme? Supprimer complètement l’algorithme? Quels impacts cela aurait-il alors sur l’engagement Facebook?

L’équilibre entre la responsabilité et les avantages est une considération importante à cet égard.