Alors que la vague de contenu génératif d'IA engloutit progressivement l'Internet au sens large, OpenAI a annoncé aujourd'hui deux nouvelles mesures visant à faciliter plus de transparence dans le contenu en ligne et à garantir que les gens soient conscients de ce qui est réel et de ce qui ne l'est pas dans les créations visuelles.

Tout d'abord, OpenAI a annoncé qu'il était rejoindre le comité directeur de la Coalition pour la provenance et l'authenticité du contenu (C2PA) pour aider à établir une norme uniforme pour la certification du contenu numérique.

Selon OpenAI :

« Développé et adopté par un large éventail d'acteurs, notamment des éditeurs de logiciels, des fabricants d'appareils photo et des plateformes en ligne, le C2PA peut être utilisé pour prouver que le contenu provient d'une source particulière.»

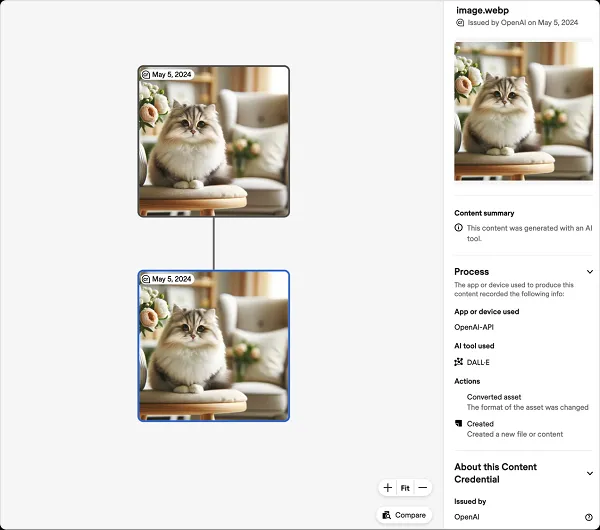

Donc, essentiellement, comme vous pouvez le voir dans cet exemple, l'objectif de l'initiative C2PA est de développer des normes Web pour le contenu généré par l'IA, qui répertorieront ensuite la source de création dans le codage du contenu, contribuant ainsi à garantir que les utilisateurs sont conscients de ce qui est artificiel. et ce qui est réel sur le Web.

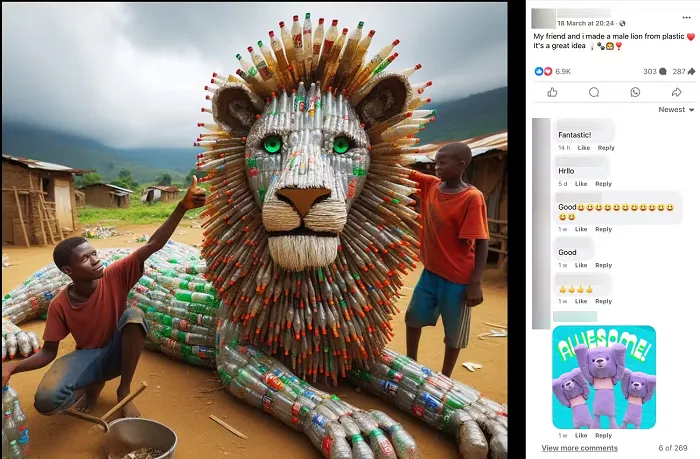

Ce qui, si cela est possible, serait extrêmement bénéfique, car les applications sociales sont de plus en plus envahies par de fausses images d'IA comme celle-ci, que beaucoup, beaucoup de gens confondent apparemment avec légitimes.

Disposer d’une méthode de vérification simple serait un grand avantage pour les dissiper, et pourrait même permettre aux plateformes de limiter également la distribution.

Mais là encore, ces mesures de protection sont également facilement atténuées par les utilisateurs Web, même légèrement avertis.

C’est là qu’intervient la prochaine initiative d’OpenAI :

« En plus de nos investissements dans C2PA, OpenAI développe également de nouvelles méthodes de provenance pour améliorer l'intégrité du contenu numérique. Cela inclut la mise en œuvre d’un filigrane inviolable – marquant le contenu numérique comme l’audio avec un signal invisible qui vise à être difficile à supprimer – ainsi que des classificateurs de détection – des outils qui utilisent l’intelligence artificielle pour évaluer la probabilité que le contenu provienne de modèles génératifs.

Les signaux invisibles dans les images créées par l’IA pourraient constituer un grand pas en avant, car même les captures d’écran et les modifications ne seront pas faciles. Il y aura probablement des pirates et des groupes plus avancés qui trouveront également des moyens de contourner ce problème, mais cela pourrait limiter considérablement les abus si cela peut être mis en œuvre efficacement.

OpenAI indique tester actuellement ces nouvelles approches avec des chercheurs externes, afin de déterminer la viabilité de ses systèmes en transparence visuelle.

Et s’il parvient à établir des méthodes améliorées de détection visuelle, cela contribuera grandement à faciliter une plus grande transparence dans la détection d’images par l’IA.

En réalité, il s’agit d’une préoccupation majeure, étant donné l’utilisation croissante d’images générées par l’IA, ainsi que l’expansion prochaine de la vidéo générée par l’IA. Et à mesure que la technologie s'améliore, il sera de plus en plus difficile de savoir ce qui est réel. C'est pourquoi le filigrane numérique avancé est une considération essentielle pour éviter la distorsion progressive de la réalité, dans tous les contextes.

Chaque plate-forme explore des mesures similaires, mais étant donné la présence d'OpenAI dans l'espace actuel de l'IA, il est essentiel qu'elle, en particulier, explore la même chose.