En février, lorsque le PDG de Meta, Mark Zuckerberg, a annoncé que la société travaillait sur une série de nouvelles initiatives d’IA, il a noté que parmi ces projets, Meta développait de nouveaux expériences avec du texte, des images, ainsi qu’avec des éléments vidéo et « multimodaux ».

Alors, que signifie « multimodal » dans ce contexte ?

Aujourd’hui, Meta a expliqué comment son IA multimodale pourrait fonctionner, avec le lancement d’ImageBind, un processus qui permet aux systèmes d’IA de mieux comprendre les entrées multiples pour des recommandations plus précises et plus réactives.

Comme l’explique Meta :

« Lorsque les humains absorbent des informations du monde, nous utilisons naturellement plusieurs sens, comme voir une rue animée et entendre le bruit des moteurs de voiture. Aujourd’hui, nous introduisons une approche qui rapproche les machines de la capacité des humains à apprendre simultanément, de manière holistique et directement à partir de nombreuses formes d’informations différentes – sans avoir besoin d’une supervision explicite. ImageBind est le premier modèle d’IA capable de lier les informations de six modalités.

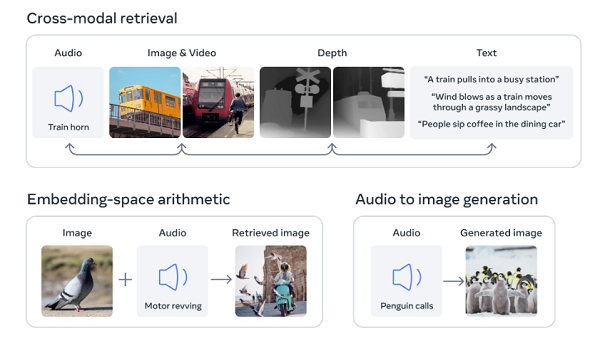

Le Le processus ImageBind permet essentiellement au système de apprendre l’association, non seulement entre le texte, l’image et la vidéo, mais aussi l’audio, ainsi que la profondeur (via des capteurs 3D), et même les entrées thermiques. Combinés, ces éléments peuvent fournir des repères spatiaux plus précis, qui peuvent ensuite permettre au système de produire des représentations et des associations plus précises, ce qui rapproche les expériences d’IA de l’émulation des réponses humaines.

« Par exemple, en utilisant ImageBind, Make-A-Scene de Meta pourrait créer des images à partir d’audio, comme créer une image basée sur les sons d’une forêt tropicale ou d’un marché animé. D’autres possibilités futures incluent des moyens plus précis de reconnaître, de connecter et de modérer le contenu, et de stimuler la conception créative, comme la génération de médias plus riches de manière plus transparente et la création de fonctions de recherche multimodales plus larges.”

Les cas d’utilisation potentiels sont importants, et si les systèmes de Meta peuvent établir un alignement plus précis entre ces entrées variables, cela pourrait faire progresser la gamme actuelle d’outils d’IA, qui sont basés sur du texte et des images, vers un tout nouveau domaine d’interactivité.

Ce qui pourrait également faciliter la création de mondes VR plus précis, un élément clé dans l’avancée de Meta vers le métaverse. Via Horizon Worlds, par exemple, les gens peuvent créer leurs propres espaces VR, mais les limitations techniques de ceux-ci, à ce stade, signifient que la plupart des expériences Horizon sont encore très basiques – comme entrer dans un jeu vidéo des années 80.

Mais si Meta peut fournir plus d’outils qui permettent à quiconque de créer ce qu’il veut en VR, simplement en le faisant exister, cela pourrait ouvrir un tout nouveau domaine de possibilités, ce qui pourrait rapidement faire de son expérience VR une option plus attrayante et engageante pour beaucoup. utilisateurs.

Nous n’en sommes pas encore là, mais des avancées comme celle-ci se dirigent vers la prochaine étape du développement du métaverse, et montrent exactement pourquoi Meta est si haut sur le potentiel de ses expériences plus immersives.

Meta note également qu’ImageBind pourrait être utilisé de manière plus immédiate pour faire avancer les processus intégrés à l’application.

« Imaginez que quelqu’un puisse prendre un enregistrement vidéo d’un coucher de soleil sur l’océan et ajouter instantanément le clip audio parfait pour l’améliorer, tandis qu’une image d’un Shih Tzu bringé pourrait donner des essais ou des modèles de profondeur de chiens similaires. Ou lorsqu’un modèle comme Make-A-Video produit une vidéo d’un carnaval, ImageBind peut suggérer un bruit de fond pour l’accompagner, créant une expérience immersive.”

Ce sont les premières utilisations du processus, et cela pourrait devenir l’une des avancées les plus importantes du processus de développement de l’IA de Meta.

Nous allons maintenant attendre de voir comment Meta cherche à l’appliquer, et si cela conduit à de nouvelles expériences AR et VR dans ses applications.

Vous pouvez en savoir plus sur ImageBind et son fonctionnement ici.