Parmi les différents cas d’utilisation de la nouvelle gamme de grands modèles de langage (LLM) et de l’IA générative basée sur de telles entrées, la génération de code est probablement l’une des considérations les plus précieuses et les plus viables.

La création de code a des réponses définitives et des paramètres existants qui peuvent être utilisés pour réaliser ce que vous voulez. Et bien que la connaissance du codage soit essentielle pour créer des systèmes efficaces et fonctionnels, la mémoire de base joue également un rôle important, ou du moins savoir où chercher pour trouver des exemples de code pertinents à fusionner dans le mix.

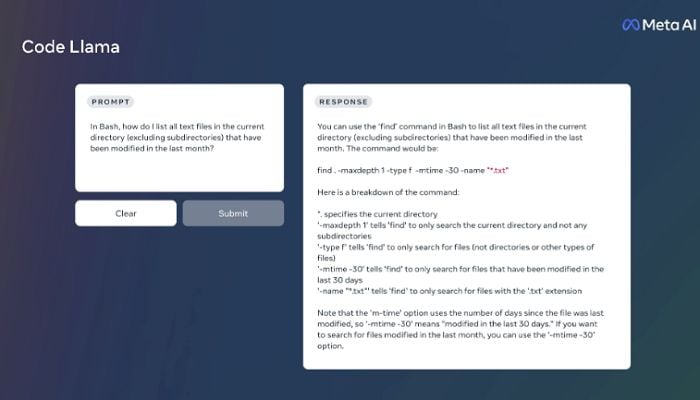

C’est pourquoi cela pourrait être important. Aujourd’hui, Meta lance « Code Llama », son dernier modèle d’IA conçu pour générer et analyser des extraits de code, afin d’aider à trouver des solutions.

Comme expliqué par Meta :

« Code Llama offre des capacités de codage améliorées. Il peut générer du code et du langage naturel sur le code, à partir d’invites de code et de langage naturel (par exemple, « Écrivez-moi une fonction qui génère la séquence de Fibonacci »). Il peut également être utilisé pour la complétion du code et le débogage. Il prend en charge la plupart des langages de programmation les plus populaires utilisés aujourd’hui, notamment Python, C++, Java, PHP, Typescript (Javascript), C#, Bash et bien d’autres encore.»

L’outil fonctionne efficacement comme un Google pour les extraits de code en particulier, en générant des jeux de codes complets et actifs en réponse aux invites textuelles.

Ce qui pourrait faire gagner beaucoup de temps. Comme indiqué, même si la connaissance du code est requise pour le débogage, la plupart des programmeurs recherchent toujours des exemples de code pour des éléments spécifiques, puis les ajoutent au mélange, bien que dans un format personnalisé.

Code Llama ne remplacera pas les humains à cet égard (car s’il y a un problème, vous devrez toujours être capable de déterminer de quoi il s’agit), mais le modèle plus raffiné et spécifique au code de Meta pourrait être un grand pas vers une meilleure… faciliter la création de code via les LLM.

Meta publie trois versions de la base Code Llama, avec respectivement 7 milliards, 13 milliards et 34 milliards de paramètres.

« Chacun de ces modèles est formé avec 500 milliards de jetons de code et de données liées au code. Les 7 milliards et 13 milliards de modèles de base et d’instruction ont également été formés avec la capacité de remplissage au milieu (FIM), leur permettant d’insérer du code dans le code existant, ce qui signifie qu’ils peuvent prendre en charge des tâches telles que la complétion de code dès la sortie de la boîte.»

Meta publie également deux versions supplémentaires, une pour Python spécifiquement et une autre alignée sur les variantes pédagogiques.

Comme indiqué, même si l’afflux actuel d’outils d’IA générative est incroyable dans ce qu’ils sont capables de faire, pour la plupart des tâches, ils sont encore trop défectueux pour être fiables, fonctionnant davantage comme des éléments complémentaires que comme des solutions singulières. Mais pour les réponses techniques, comme le code, où il existe une réponse définitive, elles pourraient être particulièrement utiles. Et si le modèle Code Llama de Meta permet de produire des éléments de code fonctionnels, il pourrait faire gagner beaucoup de temps à de nombreux programmeurs.

Vous pouvez lire la documentation complète de Code Llama ici.