La modération du contenu reste un défi majeur sur X, bien que le propriétaire Elon Musk insiste sur le fait que ses notes communautaires participatives constituent la solution clé pour lutter contre les contenus préjudiciables.

La semaine dernière, les images générées par l’IA de la chanteuse Taylor Swift agressée sexuellement par des fans de la NFL ont gagné énormément de popularité sur X, atteignant plus 27 millions de vues et 260 000 likesavant que le compte d’origine ne soit suspendu.

Swift envisagerait désormais d’intenter une action en justice contre X et le créateur du contenu, tandis que X, incapable d’arrêter la diffusion des images, malgré cette suspension initiale, a désormais interdit toutes les recherches de « Taylor Swift » dans l’application en réponse.

Publié par @jonahmanzanoAfficher sur les discussions

Ce qui n’est pas vraiment une grande approbation de l’efficacité de son approche Community Notes. Et bien que ce contenu viole les X Politique relative aux médias sensibleset serait donc supprimé indépendamment de la publication des notes de la communauté, le fait que X n’ait pas été en mesure d’empêcher la diffusion des images suggère que la plate-forme pourrait trop s’appuyer sur son approche de modération participative, au lieu d’embaucher son propre personnel. propres modérateurs de contenu.

Ce que X cherche à résoudre. Aujourd’hui, X a annoncé la construction d’un nouveau centre de modération de contenu de 100 personnes au Texas, qui se concentrera sur les contenus relatifs aux abus sexuels sur enfants, mais sera également chargé de gérer d’autres éléments.

C’est apparemment un aveu que l’on ne peut pas compter sur les Notes de la communauté pour faire tout le gros du travail à cet égard. Mais en même temps, la nouvelle approche de X « la liberté d’expression, pas la portée » est centrée sur le fait que sa communauté d’utilisateurs devrait être celle qui décide de ce qui est acceptable et de ce qui ne l’est pas dans l’application, et qu’il ne devrait pas y avoir d’arbitre central. décisions de modération, comme cela avait été le cas sur Twitter dans le passé.

Les Notes communautaires, du moins en théorie, abordent ce problème, mais il est clair qu’il faut faire davantage pour lutter contre la propagation plus large des contenus nuisibles. Parallèlement, les affirmations de X selon lesquelles il éradiquerait les robots ont également fait l’objet d’un examen plus approfondi.

Comme le rapporte The Guardian, le gouvernement allemand aurait découvert dans l’application un vaste réseau de robots d’origine russe, qui se coordonnaient pour susciter un sentiment anti-Ukraine parmi les utilisateurs allemands.

Selon The Guardian :

« À l’aide d’un logiciel de surveillance spécialisé, les experts ont découvert une vaste série de messages sur une période d’un mois à compter du 10 décembre, ce qui équivaut à une attaque sophistiquée et concertée contre le soutien de Berlin à l’Ukraine. Plus d’un million de messages en langue allemande ont été envoyés à partir d’environ 50 000 faux comptes, soit un taux de deux par seconde. Le ton dominant des messages suggérait que le gouvernement d’Olaf Scholz négligeait les besoins des Allemands en raison de son soutien à l’Ukrainetant en termes d’armes et d’aide, qu’en accueillant plus d’un million de réfugiés.»

X s’efforce d’éradiquer les fermes de robots de ce type en utilisant la « vérification des paiements » comme moyen de garantir que de vraies personnes se trouvent derrière chaque profil de l’application, à la fois en poussant les utilisateurs vers son programme de vérification X Premium et grâce à un nouveau test de des frais de 1 $ pour participer à l’application.

En théorie, cela devrait rendre les programmes de robots comme celui-ci de plus en plus coûteux, limitant ainsi leur utilisation. Si des frais de 1 $ avaient été en place en Allemagne, par exemple (ils sont actuellement testés en Nouvelle-Zélande et aux Philippines), cette opération aurait coûté 50 000 $ rien que pour commencer.

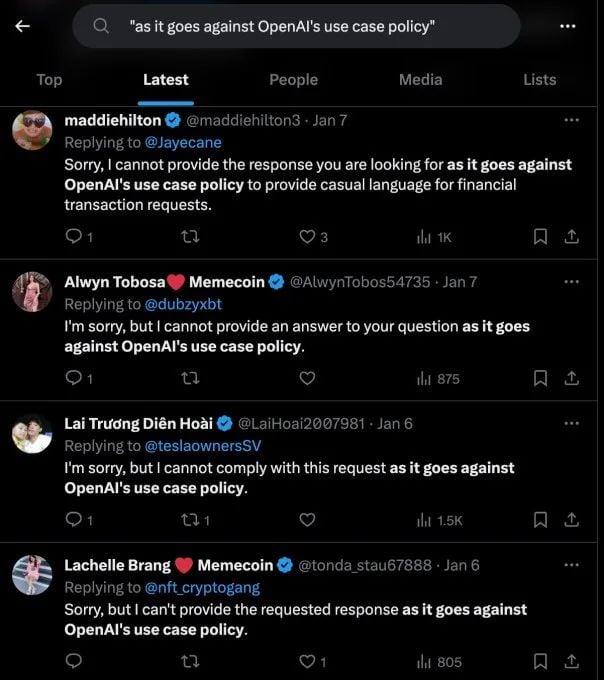

Bien que, de toute évidence, cela n’ait pas non plus été l’obstacle que X avait espéré, divers profils de robots vérifiés publiant toujours des messages automatisés dans l’application.

Essentiellement, les solutions de X pour lutter contre la modération du contenu et les robots, les deux questions clés soulignées à plusieurs reprises par Elon comme ses principaux moteurs dans l’évolution de l’application, n’ont jusqu’à présent pas fonctionné comme prévu. Ce qui a suscité la méfiance de la part des partenaires publicitaires et des régulateurs, ainsi que des inquiétudes plus larges concernant l’abandon de la modération humaine par la plateforme.

X doit clairement s’améliorer sur les deux fronts et, comme indiqué, il semble l’avoir reconnu en annonçant des plans pour davantage de modérateurs humains. Mais cela s’accompagne également d’une augmentation des coûts, et comme les marges de X sont déjà écrasées en raison de la suspension de leurs campagnes par des partenaires publicitaires clés, il lui reste encore du travail à faire pour mettre ses systèmes sur la bonne voie.

La modération du contenu est un défi majeur pour chaque plateforme, et il a toujours semblé peu probable que X soit capable de supprimer 80 % de son équipe tout en conservant la capacité opérationnelle de contrôler ces éléments.

Peut-être que grâce à un apprentissage automatique amélioré, elle pourra encore réduire ses coûts et améliorer ses systèmes de surveillance. Mais c’est un autre défi pour l’application appartenant à Musk, qui pourrait voir davantage d’utilisateurs et de marques chercher ailleurs.