Facebook a annoncé cette semaine qu’il suspendait la possibilité de cibler les publicités en excluant les groupes raciaux afin de leur donner le temps d’enquêter sur le problème. De nouveau.

Pour la deuxième fois au cours de la dernière année, une enquête a montré que les options de ciblage publicitaire complexes de Facebook peuvent être utilisées pour contourner les lois fédérales, en particulier en ce qui concerne le logement. En octobre dernier, un rapport de ProPublica a montré qu’il était possible d’utiliser la segmentation démographique « affinités ethniques » de Facebook pour éliminer des groupes raciaux spécifiques de la portée de vos annonces, en violation de la loi fédérale sur le logement.

Facebook s’est engagé à résoudre le problème et a décrit une série de mesures qu’ils prenaient pour résoudre le problème, mais plus récemment, ProPublica a repris le processus et a constaté qu’il était toujours possible d’exclure certains groupes raciaux du ciblage publicitaire.

Cela a conduit à la dernière suspension de l’option par Facebook, la directrice de l’exploitation de Facebook, Sheryl Sandberg, notant que la société était déterminée à « faire mieux ».

Mais la question se pose de savoir si cela est même possible, si un tel profilage peut être complètement éliminé, étant donné la profondeur du processus basé sur les données de Facebook.

Par exemple, en 2015, des chercheurs de l’Université de Cambridge et de l’Université de Stanford ont publié un rapport qui examinait comment l’activité Facebook des gens pouvait être utilisée comme mesure indicative de leur profil psychologique.

Ce qu’ils ont trouvé était assez étonnant – en utilisant les résultats d’une étude psychologique de 100 questions, qui avait été complétée par plus de 86 000 participants via une application, et cartographiée avec leurs goûts respectifs sur Facebook, les chercheurs ont développé un système qui pourrait ensuite, basé sur Facebook activité seule, déterminent la constitution psychologique d’une personne plus précisément que ses amis, sa famille – mieux encore que ses partenaires.

J’ai interviewé l’un des co-auteurs du rapport, le Dr Michal Kosinski, qui a expliqué la profondeur des données qu’ils ont trouvées et les idées qu’ils ont pu glaner.

« De nombreux traits intimes sont prévisibles à partir de votre empreinte numérique : fumer, boire, prendre de la drogue, l’orientation sexuelle, les opinions religieuses et politiques, etc. En fait, tout ce que nous avons essayé de prédire était prévisible, dans une certaine mesure, et assez souvent était très précis.

Kosinski a expliqué comment votre profil Facebook, à une échelle comparative suffisamment large, pouvait être très indicatif. Mis à part l’orientation sexuelle ou les habitudes personnelles (ils pouvaient détecter les fumeurs même lorsqu’ils mentaient sur le fait de fumer lors du test), ils pouvaient même prédire si vos parents étaient divorcés ou non, en se basant uniquement sur vos likes sur Facebook.

Compte tenu de cela, on peut supposer qu’un niveau de ciblage publicitaire discriminatoire et intrusif sera toujours possible via le système de Facebook, que ce soit par le biais d’une capacité directe ou indirecte.

Bien sûr, c’est le ciblage direct qui est le vrai problème, il ne devrait pas y avoir d’option consciente pour les annonceurs de cibler ou de ne pas cibler des groupes ethniques spécifiques ou des personnes en fonction de certains traits personnels. Mais étant donné la complexité des systèmes de données de Facebook, cela est et sera toujours possible dans une certaine mesure pour ceux qui savent s’en servir.

C’est ainsi que les agents russes ont pu cibler spécifiquement certains sous-ensembles d’électeurs américains avec leurs annonces électorales de 2016 – avec autant d’options de données disponibles, il existe des moyens de restreindre votre attention et d’être exposé aux personnes les plus réceptives à votre message. C’est un problème, comme le soulignent les histoires d’acteurs étrangers inspirant des manifestations et des contre-manifestations dans les villes américaines pour alimenter davantage la division.

C’est inquiétant, ce n’est pas bon. Mais encore une fois, c’est tout à fait possible.

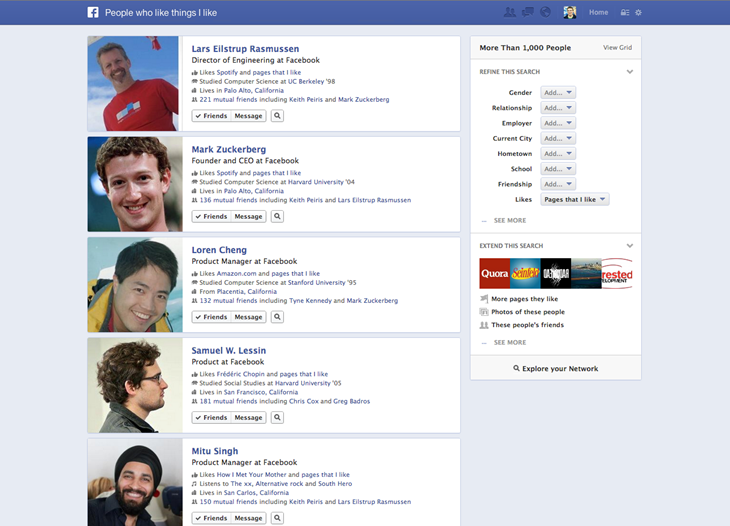

Facebook a été confronté à des problèmes similaires lorsqu’ils ont introduit leur option de recherche graphique approfondie en 2013.

Graph Search était la grande tentative de Facebook d’exploiter le marché de la recherche – plutôt que de vous montrer des résultats de recherche pertinents basés sur des requêtes Web globales, Graph Search pourrait vous fournir des informations contextuelles, basées sur ce que vos amis aiment. Recherchez « Restaurants à Londres où mes amis sont allés » et la recherche de graphiques fournit des résultats pertinents et personnalisés.

Et Graph Search était génial, il y avait un tas d’applications pour cela – mais il y avait aussi beaucoup de problèmes de confidentialité, surtout après que les utilisateurs aient trouvé des manières intrusives d’utiliser les requêtes graphiques.

Graph Search a depuis été sous-estimé en raison de sa capacité potentiellement intrusive, mais le projet met à nouveau en évidence la quantité de données que Facebook possède sur ses 2 milliards d’utilisateurs et comment ces informations peuvent être utilisées de manière néfaste entre les mains de ceux qui en savent assez. -comment.

Pour les annonceurs, c’est formidable, c’est pour cela que la plate-forme a été conçue, le moteur de ciblage le plus approfondi jamais créé. Mais en termes de problèmes de confidentialité et de discrimination potentielle – et de violations des lois existantes sur les droits de l’homme – il y a clairement des préoccupations.

Certes, Facebook doit faire tout son possible pour résoudre ces problèmes, mais des options publicitaires spécifiques comme celle-ci ne représentent en réalité qu’une petite partie de la capacité discriminatoire plus large des publicités Facebook. Vous êtes juste moins susceptible d’entendre parler des autres, car ils ne sont pas énoncés aussi clairement, mais ils existent tout de même.