Avec l’utilisation croissante de l’IA générative, Meta s’efforce d’établir de nouvelles règles autour de la divulgation de l’IA dans ses applications, ce qui non seulement obligera davantage les utilisateurs à déclarer l’utilisation de l’IA dans leur contenu, mais aussi, idéalement, à mettre en œuvre de nouveaux systèmes. pour détecter l’utilisation de l’IA, via des moyens techniques.

Ce qui ne sera pas toujours possible, car la plupart des options de filigrane numérique sont facilement détournées. Mais idéalement, Meta espère adopter de nouvelles normes industrielles autour de la détection de l’IA, en travaillant en partenariat avec d’autres fournisseurs pour améliorer la transparence de l’IA et établir de nouvelles règles de travail pour mettre en évidence ce type de flux.

Comme expliqué par Meta :

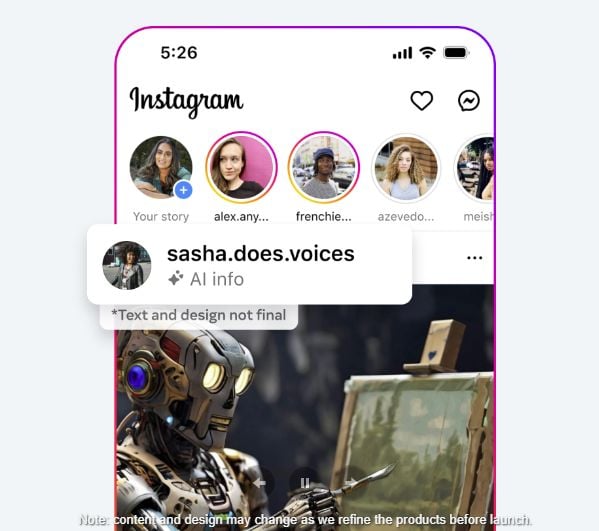

« Nous développons des outils de pointe capables d’identifier les marqueurs invisibles à grande échelle, en particulier les Informations « IA générées » dans le C2PA et IPTC normes techniques – afin que nous puissions étiqueter les images de Google, OpenAI, Microsoft, Adobe, Midjourney et Shutterstock alors qu’ils mettent en œuvre leurs projets d’ajout de métadonnées aux images créées par leurs outils.

Ces mesures techniques de détection permettront idéalement à Meta, et à d’autres plateformes, d’étiqueter le contenu créé avec l’IA générative partout où il apparaît, afin que tous les utilisateurs soient mieux informés sur le contenu synthétique.

Cela contribuera à réduire la propagation de la désinformation résultant de l’IA, bien qu’il existe des limites à cette capacité dans le paysage actuel de l’IA.

« Même si les entreprises commencent à inclure des signaux dans leurs générateurs d’images, elles n’ont pas commencé à les inclure dans les outils d’IA qui génèrent de l’audio et de la vidéo à la même échelle. Nous ne pouvons donc pas encore détecter ces signaux et étiqueter ce contenu provenant d’autres entreprises. Pendant que l’industrie travaille à cette fonctionnalité, nous ajoutons une fonctionnalité permettant aux utilisateurs de divulguer lorsqu’ils partagent une vidéo ou un audio généré par l’IA afin que nous puissions y ajouter une étiquette. Nous exigerons que les gens utilisent cet outil de divulgation et d’étiquetage lorsqu’ils publient du contenu organique avec une vidéo photoréaliste ou un audio réaliste qui a été créé ou modifié numériquement, et nous pourrons leur appliquer des sanctions s’ils ne le font pas.

Il s’agit d’une préoccupation majeure dans le développement de l’IA en général, et un sujet sur lequel Google, en particulier, a tiré la sonnette d’alarme à plusieurs reprises.

Bien que le développement de nouveaux outils d’IA générative tels que ChatGPT constitue une avancée majeure pour la technologie, Google estime que nous devrions adopter une approche plus prudente dans la diffusion de ces outils au public, en raison du risque de préjudice associé à une mauvaise utilisation.

Nous avons déjà vu des images génératives d’IA semer la confusion, à partir d’exemples plus innocents comme Le Pape en doudouneà plus sérieux, comme les conséquences d’une fausse explosion à l’extérieur du Pentagone. Sans étiquette ni confirmation, il est très difficile de dire ce qui est vrai et ce qui ne l’est pas, et bien que l’Internet au sens large ait démystifié ces exemples assez rapidement, vous pouvez voir comment, dans certains contextes, comme, par exemple, les élections, les incitations des deux côtés pourraient rendre cela possible. plus problématique.

L’étiquetage des images améliorera cela, et encore une fois, Meta affirme développer des options de filigrane numérique qui seront plus difficiles à contourner. Mais comme il le note également, l’IA audio et vidéo n’est pas encore détectable.

Et nous avons déjà vu cela utilisé par les campagnes politiques :

C’est pourquoi certains experts en IA ont exprimé à plusieurs reprises leurs inquiétudes, et il semble quelque peu problématique que nous mettions en œuvre des garanties rétrospectivement, après qu’elles ont été mises entre les mains du public.

Comme le suggère Google, nous devrions sûrement commencer par développer ces outils et systèmes, puis examiner leur déploiement.

Mais comme pour tout changement technologique, la plupart des réglementations seront rétrospectives. En effet, le gouvernement américain a commencé à réunir des groupes de travail sur la réglementation de l’IA, ce qui a mis en branle un éventuel cadre pour une meilleure gestion.

Cela prendra des années, et avec une série d’élections importantes qui se tiendront dans le monde en 2024, il semble que l’œuf et la poule dans cette situation aient été confondus.

Mais nous ne pouvons pas arrêter les progrès, car si les États-Unis ralentissent, la Chine ne le fera pas, et les pays occidentaux pourraient finir par prendre du retard. Nous devons donc aller de l’avant, ce qui ouvrira toutes sortes de failles en matière de sécurité lors de la prochaine période électorale.

Et il y a fort à parier que l’IA jouera un rôle dans la course à la présidentielle américaine.

Peut-être qu’à l’avenir, les efforts de Meta, combinés à ceux d’autres géants de la technologie et législateurs, faciliteront davantage de garanties, et il est bon qu’un travail critique soit actuellement effectué sur ce front.

Mais il est également inquiétant que nous essayions de reboucher un génie déjà libéré depuis longtemps.