Alors que Facebook prend le poids des critiques concernant la propagation du discours de haine et de la désinformation en ligne, YouTube est également une source clé, beaucoup étant désormais tributaire de la plate-forme pour les mises à jour.

En effet, une étude menée plus tôt cette année a révélé que oUn quart des vidéos YouTube les plus vues sur COVID-19 contenaient des informations trompeuses, atteignant des millions de téléspectateurs dans le monde. Des rapports ont également suggéré que YouTube promeut souvent par inadvertance des contenus extrémistes et peut endoctriner davantage les utilisateurs grâce à ses recommandations, ses liens et ses commentaires vidéo.

Ce sont des problèmes que toutes les plates-formes sociales doivent résoudre, mais YouTube et Facebook ont la plus large portée, ce qui les met à l’honneur pour faire plus pour lutter contre ces problèmes.

Et cette semaine, YouTube a donné un aperçu de la façon dont il fait exactement cela, avec une mise à jour sur la façon dont il cherche à lutter contre le discours de haine sur la plate-forme, afin de fournir un environnement plus accueillant pour tous les utilisateurs.

Selon YouTube:

« Depuis ses débuts, YouTube s’est toujours efforcé d’être un endroit où les créateurs de tous horizons peuvent avoir une voix, trouver une communauté et même créer une entreprise, y compris beaucoup de ceux qui peuvent être sous-représentés ou qui n’auraient peut-être pas eu de plate-forme. Nous nous engageons à soutenir les diverses communautés de créateurs sur YouTube et leur succès continu. «

YouTube ajoute une gamme de nouvelles mesures, dont certaines sur lesquelles il travaille depuis un certain temps, ainsi que de nouvelles idées innovantes pour une détection améliorée.

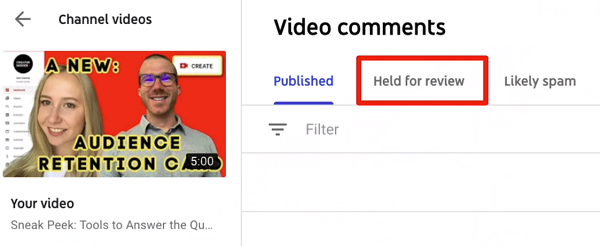

Tout d’abord, YouTube tester un nouveau filtre dans YouTube Studio qui supprimera les commentaires potentiellement inappropriés et blessants qui ont été automatiquement mis en examen.

YouTube l’a signalé en octobre – maintenant, le système de YouTube détectera les commentaires potentiellement dangereux et les déplacera vers la zone « En attente de révision ». Si le propriétaire de la chaîne choisit de ne pas agir sur eux après 60 jours, ils seront supprimés automatiquement.

Cela signifie que les propriétaires de chaînes n’auront pas à regarder ces commentaires s’ils choisissent de ne pas le faire, ce qui pourrait éviter aux gens de faire face à des remarques potentiellement abusives ou offensantes.

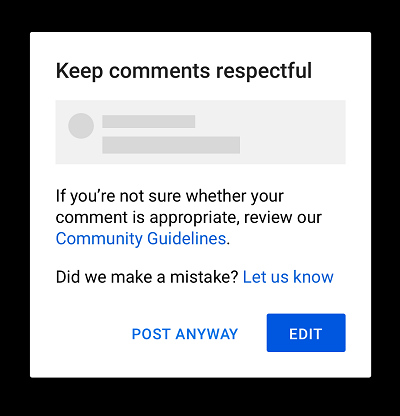

En plus de cela, YouTube ajoute également de nouveaux avertissements lorsque les utilisateurs vont publier les commentaires que ses systèmes détectent peuvent être offensants pour les autres, «leur donnant la possibilité de réfléchir avant de publier».

Instagram a mis en œuvre des avertissements similaires l’année dernière et LinkedIn a récemment ajouté sa propre variante. Ces petites invites peuvent avoir un impact important et peuvent aider à résoudre des problèmes potentiels pour lesquels le commentateur n’a peut-être même pas considéré que ce qu’il publie pouvait être inapproprié.

Ces avertissements sont apparus pour certains utilisateurs au cours des deux derniers mois.

YouTube cherche également à adopter une approche plus technologique du discours de haine en faisant correspondre le contenu de la vidéo aux commentaires publiés, ce qui pourrait aider à mieux détecter les remarques problématiques.

YouTube affirme que son travail sur ce front a déjà un impact:

« Depuis début 2019, nous avons multiplié par 46 le nombre de suppressions quotidiennes de commentaires haineux. Et au cours du dernier trimestre, plus de 1,8 million de chaînes que nous avons terminées pour avoir enfreint nos politiques, plus de 54 000 licenciements étaient dus à des propos haineux. Il s’agit du plus grand nombre de terminaisons de discours de haine en un seul trimestre et de 3 fois plus que le record précédent du deuxième trimestre de 2019, lorsque nous avons mis à jour notre politique en matière de discours de haine. «

Autre élément à cet égard, YouTube prend également de nouvelles mesures pour aborder la question de la représentation et garantir un plus grand niveau d’égalité pour tous les créateurs de l’application.

« SÀ partir de 2021, YouTube demandera aux créateurs sur une base volontaire de nous fournir leur sexe, leur orientation sexuelle, leur race et leur appartenance ethnique. Nous examinerons ensuite de près comment le contenu de différentes communautés est traité dans nos systèmes de recherche, de découverte et de monétisation. Nous rechercherons également d’éventuels schémas de haine, de harcèlement et de discrimination susceptibles d’affecter certaines communautés plus que d’autres. «

Les données fourniront à YouTube plus d’informations afin d’ajuster ses systèmes pour remédier à tout déséquilibre.

« Si nous trouvons des problèmes dans nos systèmes qui affectent des communautés spécifiques, nous nous engageons à travailler pour les résoudre. Et nous continuerons de partager avec vous nos progrès sur ces efforts. «

YouTube note que les informations collectées ne seront utilisées à aucune autre fin – comme, par exemple, le ciblage publicitaire – mais vous pouvez imaginer que certains créateurs hésiteront à fournir de telles informations, en raison de préoccupations concernant la confidentialité des données. Mais cela semble être un bon moyen de répondre à ces préoccupations et de garantir que ses systèmes fonctionnent pour offrir des opportunités à tous – si suffisamment de personnes participent et fournissent leurs détails.

Comme indiqué, toutes les plateformes doivent traiter le discours de haine, et ces problèmes ont toujours été présents, mais 2020 semble être un tournant en ce qui concerne la sensibilisation à ce sujet, les manifestations #BlackLivesMatter ouvrant les yeux de nombreuses personnes sur les inégalités sociales qu’elles pourraient pas avoir été au courant existé.

Ces mesures aideront YouTube à aborder ces problèmes – et bien que ce soit un moyen de résoudre ses divers problèmes, cela semble être un bon point de départ pour faire évoluer sa plate-forme.