Étant donné que divers groupes politiquement affiliés utilisent déjà des plates-formes numériques pour manipuler et influencer les électeurs, la montée des deepfakes est une grave préoccupation et pourrait constituer une menace majeure pour la démocratie telle que nous la connaissons.

C’est pourquoi toutes les grandes plates-formes travaillent à développer des systèmes de détection des vidéos modifiées numériquement, afin de les capturer avant qu’elles ne puissent se propager. Twitter a lancé sa politique de «médias manipulés» en février à cette fin, tandis que Facebook a cherché des moyens de faire progresser ses propres modèles de détection. Dans cette optique, en septembre, The Social Network a lancé un défi aux équipes académiques de proposer de meilleurs modèles de détection de deepfake qui pourraient être utilisés pour éliminer ces vidéos.

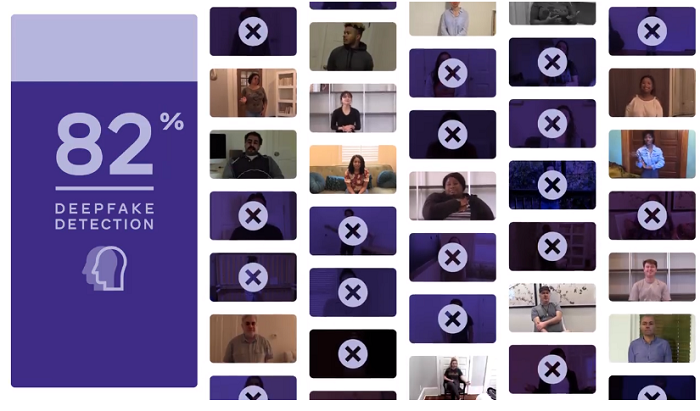

Et cette semaine, Facebook a partagé les résultats de son premier Deepfake Detection Challenge.

Comme expliqué par Facebook:

« Le DFDC a été lancé en décembre dernier et 2 114 participants ont soumis plus de 35 000 modèles au concours. Maintenant que le défi est terminé, nous partageons des détails sur les résultats et travaillons avec les gagnants pour les aider à publier le code pour les modèles de détection les plus performants. «

C’est un point clé – Facebook, en travaillant avec les équipes gagnantes, cherche à partager la base de code pour chacun des modèles gagnants, tout en prévoyant également d’ouvrir les jeux de données utilisés, afin de faire progresser la recherche sur les deepfakes plus largement.

Alors, quelle était la qualité des modèles gagnants?

Les modèles de détection les plus performants, parmi les milliers soumis, ont enregistré des taux de détection supérieurs à 82%. Ce qui est impressionnant – mais qui était basé sur l’ensemble de formation fourni, que les chercheurs ont pu étudier et affiner spécifiquement, en se concentrant sur ces exemples.

Afin de déterminer la véritable précision de ces systèmes, Facebook a également testé les modèles sur un ensemble de données « boîte noire » de 10000 clips vidéo que les participants n’avaient pas vus auparavant et auxquels ils n’avaient pas accès avant de soumettre leur code. Cela a considérablement modifié les résultats finaux.

« Le participant le plus performant était un modèle inscrit par Selim Seferbekov. Il a atteint une précision moyenne de 65,18% par rapport à l’ensemble de données de la boîte noire. En utilisant l’ensemble de données publiques, ce modèle avait été classé quatrième. De même, les autres modèles gagnants, qui étaient deuxième à cinquième lorsqu’ils ont été testés dans l’environnement de la boîte noire, se sont également classés plus bas dans le classement public. (Ils étaient respectivement 37e, 6e, 10e et 17e.) «

Comme vous pouvez le voir, les résultats ont beaucoup changé lorsqu’ils ont été appliqués à des vidéos pour lesquelles les chercheurs ne pouvaient pas s’entraîner spécifiquement. Cela montre probablement qu’il y a encore un long chemin à parcourir pour établir un système de détection des faux profonds vraiment précis – bien qu’un taux de détection de 65% soit toujours significatif et aiderait probablement à signaler de nombreuses préoccupations potentielles dans le processus de publication.

Dans l’idéal, cependant, Facebook peut augmenter ce nombre et développer un meilleur système pour déterminer les vidéos modifiées numériquement avant qu’elles ne soient partagées. Parce que, comme nous l’avons vu, une fois qu’une vidéo est mise en ligne, le fait qu’elle soit jugée fausse ou modifiée à un stade ultérieur est souvent trop tard pour arrêter les dommages causés.

Déjà, dans le cadre de ce cycle d’élection présidentielle américaine, nous avons vu plusieurs exemples de vidéos éditées ou modifiées afin de mettre en valeur certains éléments. Il y avait la vidéo controversée de Nancy Pelosi, dans laquelle Pelosi semblait brouiller ses mots, la vidéo de Michael Bloomberg où il pressait d’autres candidats sur leurs références commerciales lors d’un débat, et le Clip de Joe Biden qui avait été modifié pour montrer à Biden que les gens devraient voter pour Donald Trump.

Ces vidéos n’étaient pas des deepfakes avancés, elles utilisaient toutes des techniques d’édition assez basiques. Mais chacun d’entre eux a suscité un débat important, bien qu’ils aient été fortement édités, et se sont avérés être le cas. Même lorsqu’ils se sont révélés être édités, les débats ont continué. Vous ne pouvez qu’imaginer les dégâts qu’un deepfake suffisamment convaincant pourrait faire dans le même processus.

Et nous sommes en effet susceptibles de découvrir à quel point les deepfakes peuvent faire des dégâts. Au fur et à mesure que la course aux élections américaines de 2020 se réchauffe, il semble de plus en plus probable qu’à un moment donné, une vidéo deepfake quelconque entre en jeu.

Comment cela changera-t-il la course? Comment cela modifiera-t-il le comportement des électeurs? Les plateformes numériques peuvent-elles détecter et éliminer ce type de problème avant qu’il ne se concrétise?

Il se pourrait juste qu’à la suite de l’élection, une vidéo deepfake soit au centre de l’attention, tout comme Cambridge Analytica est devenue la cible après 2016. Facebook s’efforce d’éviter ce résultat, et cela pourrait finir par apporter un effort crucial.

Vous pouvez en savoir plus sur le défi de détection Deepfake de Facebook ilré.